想实现延迟低于100毫秒(ms)的实时音频翻译吗?这已不再是遥不可及的梦想。 有道将深入探讨自建实时音频翻译管道的核心技术与挑战,并提供一份详尽的实战教程,教您如何利用有道智云AI开放平台的强大能力,轻松构建一个高性能、低延迟的实时翻译系统。无论您是开发跨国会议应用、直播字幕、还是智能客服,有道都将为您提供从理论到实践的完整解决方案。

文章目录 (Table of Contents)

- 为何构建低延迟实时音频翻译如此具有挑战性?

- 实时音频翻译系统的核心架构是怎样的?

- 实现亚秒级响应的关键:为何选择有道智云集成API方案?

- 手把手实战:用有道API搭建你的实时翻译管道

- 进阶优化与最佳实践

- 总结:立即开启你的无障碍沟通新时代

为何构建低延迟实时音频翻译如此具有挑战性?

在深入技术细节之前,我们必须理解为什么“实时”和“低延迟”是这个领域最大的技术壁垒。用户对实时翻译的期望非常高,任何可感知的延迟都会严重破坏沟通的连贯性。这背后涉及两个核心难题:延迟的累积效应和多维度的技术权衡。

延迟的“雪球效应”:揭秘翻译管道中的时间成本

一个完整的实时音频翻译流程就像一场接力赛,每一棒选手都需要时间。这个过程通常包括:

- 音频采集与传输延迟: 从麦克风捕捉声音,分块(chunk),再通过网络传输到服务器。

- 语音识别 (ASR) 延迟: 服务器接收到音频块,将其转换成文字。流式ASR虽然可以边听边识别,但仍需累积一定语音信息才能输出稳定结果。

- 机器翻译 (MT) 延迟: ASR输出的文本被送入翻译引擎。引擎需要理解上下文才能给出精准翻译,这同样需要时间。

- 结果回传延迟: 翻译好的文本或合成的语音通过网络传回给用户端。

这些延迟会像雪球一样越滚越大。如果ASR延迟50ms,MT延迟40ms,再加上网络传输的几十毫秒,总延迟很容易就超过100ms甚至200ms,这在需要即时反馈的场景中是无法接受的。要实现低于100ms的目标,必须对整个管道进行极致的端到端优化。

速度、准确度与成本:难以平衡的“不可能三角”

开发者在构建系统时,往往面临一个经典的“不可能三角”困境:

- 速度 (Latency): 为了追求极致的速度,模型可能需要在信息不完整的情况下做出判断,这会牺牲准确度。

- 准确度 (Accuracy): 要想获得更精准的翻译,模型需要等待更完整的句子结构和上下文,这必然会增加延迟。例如,中文和英文的语序不同,“我今天要去公园”在翻译成英文前,模型最好能听到“公园”这个宾语。

- 成本 (Cost): 维持一个高并发、低延迟的强大AI模型集群需要巨大的计算资源,这直接关系到服务的使用成本。

自建系统意味着你需要分别采购、集成和优化ASR、MT服务,这不仅技术复杂度高,而且难以在三者之间找到最佳平衡点。而一个优秀的商用API,如有道智云,已经在内部通过海量数据和工程优化,为您找到了这个“甜蜜点”。

实时音频翻译系统的核心架构是怎样的?

一个标准的实时音频翻译系统,无论自建还是使用API,其内部逻辑都遵循一个清晰的模块化架构。理解这个架构有助于我们更好地利用API并进行定制开发。

模块一:实时音频流捕获与预处理

这是整个管道的起点。客户端(如浏览器、App)通过麦克风接口捕获连续的音频数据。为了实现流式处理,这些数据不能等说完话再全部发送,而是要被切分成固定大小的音频帧(Audio Frame),例如每40ms或100ms发送一次。同时,还需要进行预处理,如统一采样率(如16kHz)、位深和声道,以满足后续ASR模块的要求。

模块二:流式语音识别 (Streaming ASR)

这是将“说”变成“字”的关键。与一次性识别整段音频的ASR不同,流式ASR能够接收连续的音频帧,并在极短时间内返回中间和最终的识别结果。它会随着语音的输入不断修正前面的识别文本,实现“即说即出字”的效果。这是降低感知延迟的核心技术之一。

模块三:高速机器翻译 (MT)

ASR输出的文本流被立刻送入机器翻译模块。这里的挑战在于,输入文本是不完整的、动态变化的。高性能的MT引擎需要具备“流式翻译”或对不完整句子的快速翻译能力,同时利用上下文信息保证翻译质量。有道自研的NMT(神经网络机器翻译)技术在这一领域表现卓越,能够快速响应并提供高质量的译文。

模块四:语音合成 (TTS) – 可选输出

如果最终需要以语音形式输出翻译结果,就需要TTS模块。它将翻译好的文本转换成自然流畅的语音。为了保持整体低延迟,TTS服务也必须是“流式”的,即接收到一小段文本就能开始合成并播放音频,而不是等整段译文生成后再开始合成。

实现亚秒级响应的关键:为何选择有道智云集成API方案?

了解了架构的复杂性后,我们就能明白为何一个高度集成的API是实现低延迟目标的捷径。有道智云的实时语音翻译API并非简单地将ASR和MT服务进行拼接,而是从底层进行了深度整合与优化。

端到端整合:一次API调用,完成ASR+MT全流程

传统方案需要您发起一次WebSocket连接给ASR服务,接收到文本后再通过HTTP请求发送给MT服务。这中间存在两次网络交互和数据中转的开销。而有道智云的方案将ASR和MT封装在同一个API调用中。您只需建立一个到有道服务器的连接,持续发送音频流,就能直接接收到最终的翻译结果。这种架构极大地减少了网络跳数和内部处理延迟,是实现低于100ms响应的根本保障。

领先的流式ASR技术:即说即识,精准捕捉

有道在语音识别领域深耕多年,其流式ASR技术不仅速度快,而且准确率高。它能够智能地判断一句话是否结束(VAD,Voice Activity Detection),并快速返回稳定的识别结果。这为后续的翻译模块提供了高质量、低延迟的输入源,避免了“垃圾进,垃圾出”的问题。

卓越的神经网络机器翻译 (NMT) 引擎

作为公司的核心技术,有道的NMT引擎享誉全球。该引擎针对实时场景进行了特别优化,能够在接收到不完整的上文时进行预测性翻译,并随着上下文的丰富动态调整译文,确保了翻译的流畅性和准确性。它不仅仅是逐字翻译,而是真正理解了语义和语境。

手把手实战:用有道API搭建你的实时翻译管道

理论讲完了,现在进入最激动人心的实战环节。我们将使用Python来调用有道智云的实时语音翻译API,构建一个简单的命令行实时翻译工具。

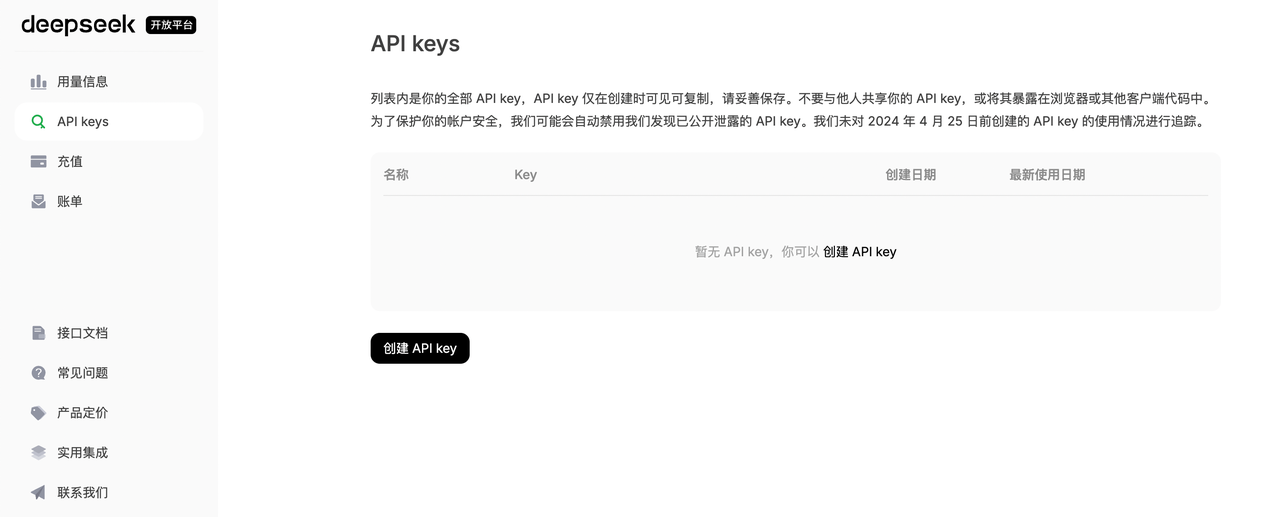

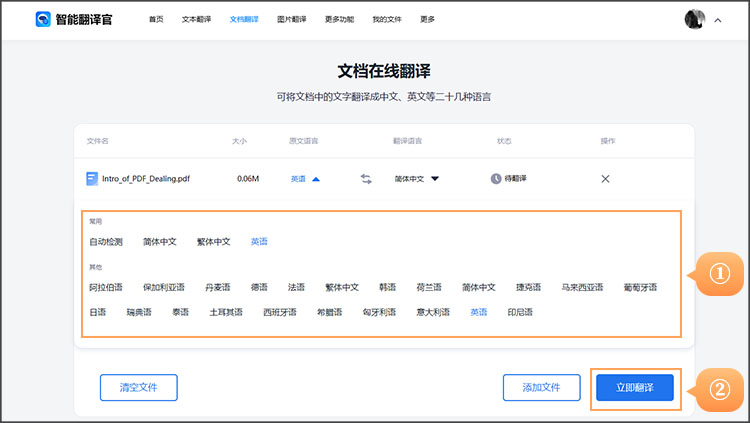

第一步:准备工作 – 注册并获取有道智云API密钥

- 访问有道智云AI开放平台官方网站。

- 注册并登录您的账号,进入“控制台”。

- 在“我的应用”中创建一个新应用,选择您需要的服务(例如“自然语言翻译”)。

- 创建成功后,您将获得一个“应用ID (appKey)”和“应用密钥 (appSecret)”。请务必妥善保管,这是您调用API的身份凭证。

第二步:理解核心API – “实时语音翻译”接口详解

有道的实时语音翻译服务通常通过WebSocket协议提供。您需要向指定的URL发起WebSocket连接,并在连接成功后,按照协议要求发送数据。

- 连接: 建立连接时,需要在URL参数中包含应用ID、时间戳、签名等认证信息。

- 发送: 连接成功后,持续将捕获到的音频二进制数据(如PCM格式)作为消息发送给服务器。

- 接收: 服务器会实时地将识别和翻译结果通过WebSocket消息推送回客户端。返回的数据通常是JSON格式,包含了识别的原文、翻译的译文、以及是否是最终结果等状态信息。

第三步:代码实战 – Python实现实时音频翻译(附完整示例)

以下是一个简化的Python示例,演示了如何连接API、发送本地音频文件模拟的音频流,并接收翻译结果。(注:实际应用中,您需要用`pyaudio`等库来实时捕获麦克风音频流)。

# 注意:这是一个示例代码,实际API调用方式请参考官方最新文档

# 您需要安装 `websocket-client` 库: pip install websocket-client

import websocket

import threading

import time

import hashlib

import uuid

# --- 配置您的密钥 ---

APP_KEY = '您的应用ID'

APP_SECRET = '您的应用密钥'

# --------------------

def get_sign(salt, curtime):

"""生成签名"""

sign_str = APP_KEY + salt + curtime + APP_SECRET

hash_object = hashlib.sha256(sign_str.encode('utf-8'))

return hash_object.hexdigest()

def on_message(ws, message):

"""处理服务器返回的消息"""

print(f"收到结果: {message}")

def on_error(ws, error):

"""处理错误"""

print(f"发生错误: {error}")

def on_close(ws, close_status_code, close_msg):

"""处理连接关闭"""

print("### 连接已关闭 ###")

def on_open(ws):

"""连接建立后,开始发送音频数据"""

def run(*args):

# 这里以读取本地文件为例,模拟音频流

# 真实场景中,这里应为从麦克风读取数据的循环

filepath = 'path/to/your/audio.pcm'

chunk_size = 1280 # 每次发送的字节数

with open(filepath, 'rb') as f:

while True:

chunk = f.read(chunk_size)

if not chunk:

# 音频发送完毕,发送结束指令

ws.send('{"end": "true"}')

break

ws.send(chunk, websocket.ABNF.OPCODE_BINARY)

# 控制发送速率,模拟真实说话速度

time.sleep(0.04)

print("音频数据发送完毕")

threading.Thread(target=run).start()

if __name__ == "__main__":

# --- 构建WebSocket连接URL ---

curtime = str(int(time.time()))

salt = str(uuid.uuid1())

sign = get_sign(salt, curtime)

# API URL, 请以官方文档为准

ws_url = f"wss://openapi.youdao.com/stream_speech_trans"

params = f"?appKey={APP_KEY}&salt={salt}&curtime={curtime}&sign={sign}&signType=v3&from=zh-CHS&to=en&format=pcm&rate=16000"

full_url = ws_url + params

print(f"正在连接到: {full_url}")

# ---------------------------

websocket.enableTrace(True)

ws = websocket.WebSocketApp(full_url,

on_open=on_open,

on_message=on_message,

on_error=on_error,

on_close=on_close)

ws.run_forever()

第四步:关键参数解读与延迟优化配置

在构建连接URL时,您传递的参数直接影响翻译效果和延迟。以下是一些关键参数:

| 参数名 | 说明 | 优化建议 |

|---|---|---|

| from | 源语言 | 准确指定,例如 `zh-CHS` 代表中文。 |

| to | 目标语言 | 准确指定,例如 `en` 代表英文。 |

| format | 音频格式 | 使用API支持的原始格式,如`pcm`,避免在客户端进行耗时转码。 |

| rate | 音频采样率 | 通常使用`16000` (16kHz),这是语音识别领域的标准。请确保您的音频源与此匹配。 |

| chunk_size | 音频块大小 | 这是一个核心优化点。块太小会增加网络请求频率,块太大会增加采集延迟。通常40ms~100ms对应的字节数(如1280字节@16kHz 16bit)是一个很好的起点。 |

进阶优化与最佳实践

除了代码层面的实现,还有一些宏观策略可以进一步提升您的应用性能。

网络环境优化:选择最近的服务器节点

物理距离是网络延迟的主要来源。尽管有道智云在全球部署了节点,但您的用户或服务器与有道API服务器之间的网络质量至关重要。如果您的应用主要服务特定区域的用户,请确保您的服务器部署在该区域,以减少网络往返时间 (RTT)。

处理边界情况:标点、断句与情绪保留

实时翻译不仅仅是文字转换。一个优秀的系统需要智能处理更多细节。有道API返回的结果中通常会包含是否为一句话结束的标记。您可以利用这个标记来决定何时添加标点符号,或者何时将翻译结果完整地展示给用户。对于更高级的应用,虽然当前技术难以完美传递情绪,但通过分析ASR结果中的语气词,并结合上下文,可以在一定程度上优化最终呈现给用户的体验。

总结:立即开启你的无障碍沟通新时代

自建一个低于100ms延迟的实时音频翻译管道,在过去是一项艰巨的系统工程。但今天,借助有道智云AI开放平台这样成熟、强大且高度集成的API服务,开发者可以将精力从复杂的基础设施和算法优化中解放出来,专注于应用本身的创新和用户体验。通过有道的介绍和教程,您已经掌握了从理论架构到代码实践的全过程。现在,就去获取您的API密钥,开始构建属于您的下一代实时沟通应用吧!