有道翻译通过其自研的神经网络翻译模型(YNMT),利用海量高质量双语数据进行深度学习训练,结合先进算法与强大算力,实现精准、流畅且智能的翻译效果。

目录

1. 什么是有道神经网络翻译(YNMT)?

1.1. 从统计到神经网络:一场翻译技术的革命

1.2. YNMT的核心架构:Transformer模型解析

2. 有道翻译训练的三大支柱:数据、算法与算力

2.1. “原料”之本:高质量平行语料库的构建

2.2. “炼金术”:数据增强与回译技术

2.3. “熔炉”之力:GPU集群与分布式训练

3. 训练过程全解析:有道翻译模型是如何“学习”的?

3.1. 第一步:监督式学习与模型初始化

3.2. 第二步:领域自适应与微调

3.3. 第三步:质量评估与迭代优化

4. 技术如何赋能产品?有道翻译的应用场景

当我们使用有道的产品进行翻译时,背后是其强大的神经网络翻译(NMT)技术在默默工作。这项技术早已不是过去那种生硬、机械的词语替换。有道作为国内最早投入神经网络翻译研究并将其大规模应用的公司之一,其自研的有道神经网络翻译模型(YNMT)已成为行业标杆。它使得机器翻译的质量发生了质的飞跃,让译文更贴近人类的表达习惯。

什么是有道神经网络翻译(YNMT)?

有道神经网络翻译(Youdao Neural Machine Translation, YNMT)是驱动有道所有翻译产品与服务的核心引擎。它并非一个单一的程序,而是一个庞大且复杂的深度学习系统,旨在模仿人类大脑处理语言的方式,从而理解和生成自然、准确的译文。这个系统的出现,标志着机器翻译进入了一个全新的智能时代。

从统计到神经网络:一场翻译技术的革命

在神经网络翻译(NMT)普及之前,主流技术是统计机器翻译(SMT)。SMT模型基于大量的双语文本,通过统计词语、短语的对应概率来进行翻译。这种方法的译文常常显得支离破碎,因为它难以理解整个句子的语法结构和深层语义,只是在做一种“概率最大”的拼凑工作。

NMT的出现彻底改变了这一局面。它采用端到端的深度学习模型,将整个源语言句子编码成一个包含丰富语义信息的向量,然后再将这个向量解码成目标语言句子。这个过程使得模型能够通盘理解句子的整体含义、语序和上下文关系,因此生成的译文在流畅度和准确性上远超SMT,实现了从“拼凑”到“创作”的跨越。

YNMT的核心架构:Transformer模型解析

目前,YNMT与其他世界顶级的翻译模型一样,其核心架构是基于强大的Transformer模型。Transformer模型于2017年被提出,其革命性的“自注意力机制”(Self-Attention Mechanism)是关键。该机制允许模型在处理一个词时,能够同时关注到句子中所有其他词语,并计算它们之间的关联强度。

这种机制的优势在于,它能极好地捕捉长距离的依赖关系。例如,在翻译“我昨天买的书,就是桌子上那本红色的,非常有趣”时,模型能够准确地将“有趣”与主语“书”关联起来,而不会被中间长长的修饰成分所迷惑。有道的技术团队在开源的Transformer模型基础上进行了大量创新和优化,使其更适合多语言、多场景的复杂翻译任务,这也是YNMT在多次国际机器翻译大赛(如WMT)中夺冠的秘密武器。

有道翻译训练的三大支柱:数据、算法与算力

一个顶级的翻译模型,其诞生离不开三大核心要素的支撑:海量且高质量的数据、先进的算法模型以及支撑这一切的强大计算能力。这三者相辅相成,共同决定了翻译质量的上限。

| 支柱 (Pillar) | 核心作用 (Core Function) | 有道实践 (Youdao’s Practice) |

|---|---|---|

| 海量数据 (Massive Data) | 为模型提供学习原料,决定翻译质量的上限 | 构建亿万级高质量平行语料库,通过数据清洗、回译等技术持续扩充与优化 |

| 先进算法 (Advanced Algorithm) | 构建高效的学习模型,提升翻译的智能性与准确性 | 基于Transformer持续迭代自研YNMT模型,针对性优化长句、口语等场景 |

| 强大算力 (Powerful Computing Power) | 支撑大规模模型训练,缩短技术迭代周期 | 部署大规模GPU集群,利用分布式训练框架高效完成模型训练与推理 |

“原料”之本:高质量平行语料库的构建

数据是AI模型的“食粮”,其质量和数量直接决定了模型的“智商”。有道翻译的训练依赖于规模庞大的平行语料库,即包含源语言文本和其对应的人工翻译译文的数据集。这些数据来源广泛,包括但不限于公开的学术数据集、网络公开内容抓取、以及与内容提供方合作获取的授权数据。

然而,原始数据往往混杂着大量噪声,如格式错误、错译、漏译等。因此,数据清洗和筛选是至关重要的一步。有道利用自动化脚本和AI模型对数据进行多轮清洗,剔除低质量数据,同时结合人工抽样审核,确保投喂给模型的每一条数据都是“高营养”的,为训练出高质量的翻译模型打下坚实基础。

“炼金术”:数据增强与回译技术

即使拥有海量的平行语料,也无法覆盖所有语言现象。为了进一步提升模型的泛化能力和翻译流畅度,有道广泛采用一种被称为“回译”(Back-translation)的数据增强技术。具体做法是:利用一个反向的翻译模型(例如,一个已经训练好的英译中模型),去翻译海量的中文单语语料(如新闻、小说),从而生成大量的“伪”英中平行句对。

虽然这些“伪”句对的英文部分是机器生成的,但其对应的中文却是地道的母语表达。通过将这些数据加入训练集,模型能够学习到更多样、更自然的语言表达方式,极大地提升了翻译的流畅度和地道性。这种技术是近年来机器翻译质量取得突破性进展的关键因素之一。

“熔炉”之力:GPU集群与分布式训练

神经网络翻译模型的参数量动辄上亿,训练过程需要进行天文数字级别的数学运算。如果没有强大的计算能力作为支撑,训练一个模型可能需要数年时间,这在商业应用中是不可接受的。为此,有道投入巨资构建了由数千块高性能GPU(图形处理器)组成的计算集群。

同时,为了充分利用这些硬件资源,有道还研发了高效的分布式训练框架。该框架可以将一个庞大的训练任务拆分到数百甚至上千块GPU上并行处理,从而将原本需要数月才能完成的训练周期缩短至几天甚至几小时。强大的算力不仅加速了模型的训练,更使得快速的技术迭代和优化成为可能。

训练过程全解析:有道翻译模型是如何“学习”的?

拥有了数据、算法和算力,接下来的问题是,模型具体是如何“学习”翻译的?这个过程可以被形象地分为几个关键步骤,就像一个学生从入门到精通的成长路径。

第一步:监督式学习与模型初始化

训练的初始阶段采用的是监督式学习。这好比给一个学生一本带有标准答案的练习册。训练时,系统会将成对的中英文句子(平行语料)输入给YNMT模型。模型会根据中文句子生成一个英文译文,然后系统会将这个译文与“标准答案”(人工翻译的译文)进行比较,计算两者之间的差异(即“损失”)。

接着,通过一种名为“反向传播”的算法,模型会根据这个差异自动微调其内部数以亿计的参数,目标是让下一次生成译文时,与标准答案的差异变得更小。这个过程会重复上亿次,每一次迭代,模型都在朝着更准确的方向进化,逐步学会两种语言之间的映射关系。

第二步:领域自适应与微调

通过海量通用语料训练出的模型,可以很好地处理日常对话和通用文本,但对于特定领域,如医学、法律、金融或古诗文,其专业术语和表达习惯有很高的壁垒。直接使用通用模型翻译这些内容,效果往往不尽人意。

为了解决这个问题,有道采用了领域自适应(Domain Adaptation)和微调(Fine-tuning)技术。具体来说,是在通用模型的基础上,使用少量但高质量的特定领域数据(如医学论文、法律条文)对其进行“二次训练”。这个过程能让模型快速掌握该领域的术语和独特的句式结构,从而大幅提升在专业场景下的翻译准确性。

第三步:质量评估与迭代优化

如何判断一个新训练出的模型比旧模型更好?这需要一套科学的评估体系。评估方法主要分为两种:自动化评估和人工评估。

自动化评估通常使用BLEU等指标,通过计算机器译文与参考译文之间的词语重合度来打分,这种方法速度快,适合在训练过程中快速监控模型表现。但BLEU分高并不完全代表翻译质量好。因此,人工评估是不可或缺的黄金标准。有道会组织专业的译员团队,从“准确性”、“流畅度”和“忠实度”等多个维度对译文进行打分。只有在各项人工评估指标上都取得显著提升的新模型,才会被最终部署上线,为用户提供服务。

技术如何赋能产品?有道翻译的应用场景

尖端的翻译技术最终要落实到产品,为用户创造价值。有道强大的YNMT模型已经深度融入其全系智能学习产品中,将复杂的AI能力转化为简单易用的功能。

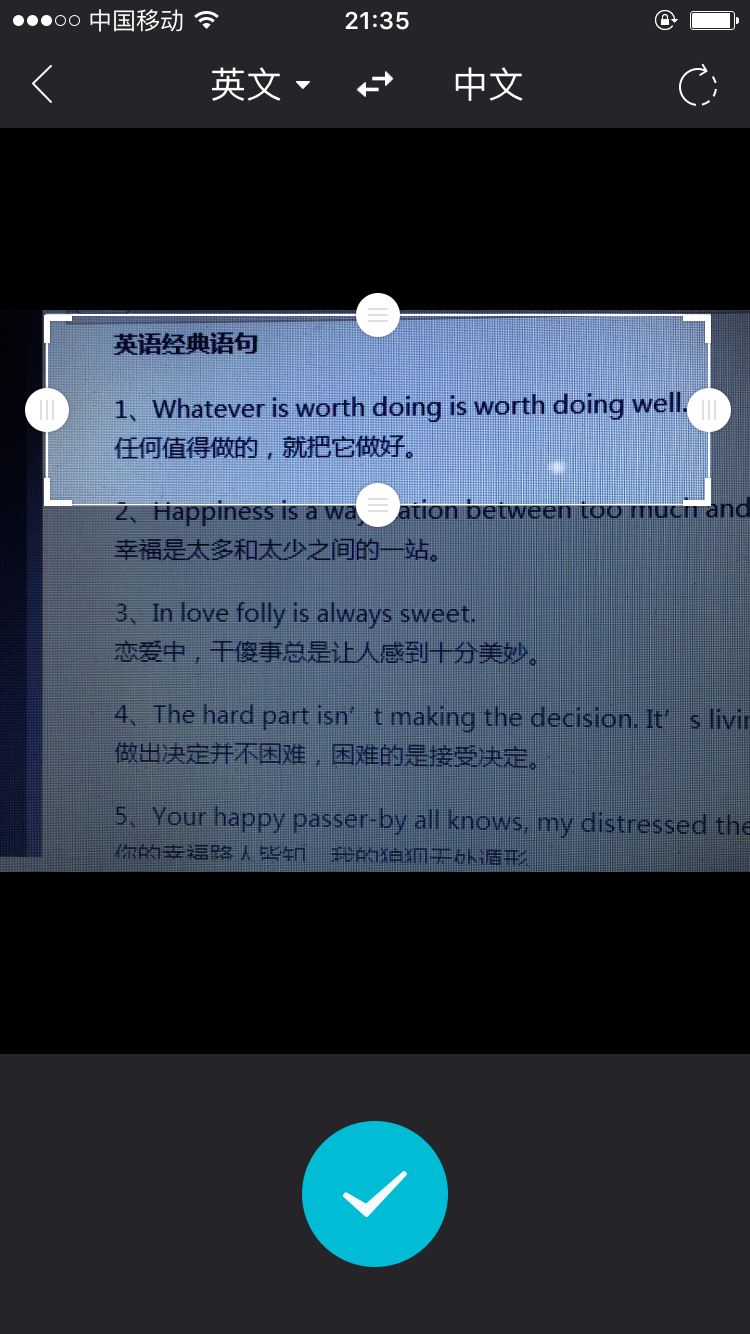

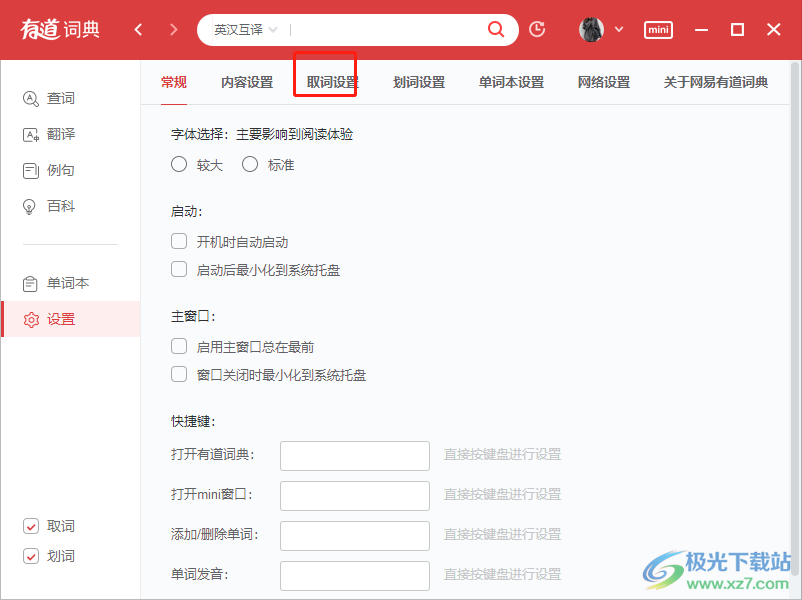

在大家熟悉的有道词典App中,无论是单词释义、例句展示还是长段落翻译,背后都是YNMT在提供支持。模型对上下文的深刻理解,使得App能够提供更符合语境的释义和更地道的例句,帮助用户更好地理解和运用语言。

在硬件产品上,技术的赋能作用更为直观。例如,有道词典笔能够在不联网的情况下实现精准的扫描翻译,这得益于有道工程师们对庞大的NMT模型进行了极致的压缩和优化,使其能高效运行在小小的笔身芯片中。而有道翻译王这样的口袋翻译设备,则集成了语音识别、机器翻译和语音合成三大AI技术,为跨语言交流提供了无缝的体验,无论是出国旅游还是商务洽谈,都能轻松应对。

除此之外,有道的翻译技术还通过开放平台(API)的形式,为众多企业和开发者提供文档翻译、视频实时字幕、网站本地化等服务。从个人学习到商业应用,有道通过不断精进的翻译训练技术,正在打破语言的壁垒,让沟通与知识获取变得更加简单和高效。