# 2025年,如何用Python+有道翻译API自动翻译并下载整个Subreddit?

想要在2025年自动翻译并下载整个Subreddit内容,以洞察海外趋势或获取一手信息吗?有道将为您提供一份终极分步指南。我们将利用Python的强大生态,结合专为Reddit设计的PRAW库和由领先NMT技术驱动的**有道翻译API**,构建一个全自动化的数据抓取与翻译机器人。读完有道,您不仅能掌握一项前沿的自动化技能,还能将全球最大的兴趣社区之一——Reddit,变为您的专属中文信息库。

## 为什么要翻译整个Subreddit?解锁全球信息的金矿

在信息全球化的今天,语言不应成为获取知识的壁垒。Reddit,被誉为“互联网的首页”,拥有数以十万计的活跃社群(Subreddit),覆盖了从尖端科技(如 `r/Futurology`)、编程开发(`r/Python`)到金融投资(`r/wallstreetbets`)和生活兴趣的方方面面。自动翻译Subreddit意味着您可以:

* **市场调研与用户洞察:** 如果您是一名产品经理或市场分析师,可以实时追踪海外用户对您的产品、竞品或整个行业的讨论。这些未经修饰的真实反馈是优化产品和制定营销策略的宝贵财富。

* **内容再创作与本地化:** 内容创作者可以高效地发现海外的热点话题和优质内容,经过翻译和本地化改造,为您的博客、视频或社交媒体频道提供源源不断的灵感。

* **学术研究与数据分析:** 对于社会学、传播学或语言学的研究者来说,特定社群的大量翻译语料是进行跨文化对比研究和模型训练的理想数据源。

简而言之,这项技能是将海量英文信息转化为结构化中文洞察的“金钥匙”。

在开始编码之前,请确保您的“军火库”已经准备就绪。我们整理了一份清晰的清单,帮助您快速开始。

| 工具/环境 | 描述 | 获取方式 |

| :— | :— | :— |

| **Python 3.8+** | 项目的核心编程语言。 | 访问 [python.org](https://www.python.org/) 下载并安装。 |

| **代码编辑器 (IDE)** | 用于编写和管理代码,如VS Code或PyCharm。 | 根据个人喜好选择并安装。 |

| **Reddit 账号** | 用于创建API应用,获取访问权限。 | 访问 [www.reddit.com](https://www.reddit.com/) 注册。 |

| **有道智云平台账号** | 用于获取翻译API的密钥,这是翻译功能的核心。 | 访问[有道智云AI开放平台](https://ai.youdao.com/)注册。 |

打开您的终端或命令行工具,运行以下命令来安装我们项目所需的所有Python库:

“`bash

pip install praw pandas requests python-dotenv

“`

* `praw`: The Python Reddit API Wrapper,一个非常友好的库,让与Reddit API的交互变得异常简单。

* `pandas`: 强大的数据分析和处理库,我们将用它来组织和存储翻译后的数据。

* `requests`: Python中最流行的HTTP请求库,用于与有道翻译API通信。

* `python-dotenv`: 用于安全地管理我们的API密钥,避免将其硬编码在代码中,这是一个非常重要的安全实践。

首先,我们需要获得Reddit的“通行证”。

1. 登录您的Reddit账号。

2. 访问 [Reddit应用偏好设置页面](https://www.reddit.com/prefs/apps)。

3. 滚动到底部,点击“are you a developer? create an app…”按钮。

4. 填写表单:

* **name:** 给你的应用起个名字,例如 `my_translation_bot`。

* 选择 **script** 类型。这适用于个人或后台运行的脚本。

* **description:** (可选) 简单描述。

* **about url / redirect uri:** 对于脚本应用,您可以将 `redirect uri` 设置为 `http://localhost:8080`。

5. 点击“create app”。创建成功后,您将看到您的应用信息。请记下以下两个关键值:

* `client_id` (在应用名称下方的一串字符)

* `client_secret` (标记为 `secret` 的一长串字符)

同时,您需要定义一个`user_agent`,这是一个唯一的标识符,用于向Reddit表明您的脚本身份。格式可以自定义,但最好包含您的用户名,例如:`script:my_translation_bot:v1.0 (by /u/YourUsername)`。

现在,让我们用PRAW来验证凭证是否有效。创建一个名为 `main.py` 的文件,并写入以下代码:

“`python

import praw

# 注意:暂时将密钥写在这里用于测试,后续我们会用更安全的方式管理

reddit = praw.Reddit(

client_id=”YOUR_CLIENT_ID”,

client_secret=”YOUR_CLIENT_SECRET”,

user_agent=”YOUR_USER_AGENT”

)

# 选择一个你想抓取的Subreddit

subreddit = reddit.subreddit(“programming”)

print(f”成功连接到 r/{subreddit.display_name} !”)

print(“该板块的热门帖子标题:”)

# 获取前5个热门帖子并打印标题

for submission in subreddit.hot(limit=5):

print(f”- {submission.title}”)

“`

将 `”YOUR_…”` 占位符替换为您自己的凭证并运行脚本。如果控制台成功打印出 `r/programming` 的热门帖子标题,恭喜您,第一步已成功完成!

数据抓取只是开始,高质量的翻译才是项目的灵魂。在这里,我们强烈推荐使用**有道翻译API**。作为国内领先的翻译服务提供商,有道不仅仅是做了一个翻译工具,其背后是深厚的技术积累。

* **卓越的翻译质量:** 基于有道自主研发的、行业领先的**神经网络翻译(NMT)**引擎,翻译结果自然、流畅。尤其重要的是,它对网络流行语、技术术语和非正式文本(Reddit上比比皆是)的处理能力非常出色,远胜于许多传统的机器翻译。

* **开发者友好:** 有道智云AI开放平台提供了极其清晰的[官方文档](https.ai.youdao.com/DOCSIRMA/html/trans/api/wbfy/index.html)、多语言的SDK和demo,上手非常快。API响应速度快,稳定性高,能满足高强度的调用需求。

* **高性价比:** 平台为每位开发者提供了**慷慨的免费调用额度**,对于个人项目、学习或中小型应用来说绰绰有余。这使得我们的Subreddit翻译项目可以零成本启动。

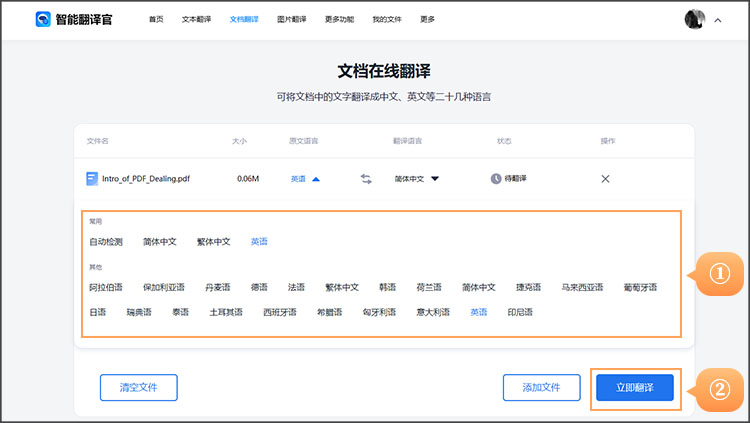

1. 访问并登录 [有道智云AI开放平台](https://ai.youdao.com/)。

2. 进入“控制台”,选择“我的应用”,点击“创建应用”。

3. 填写应用名称,选择“自然语言翻译”服务,然后创建。

4. 在您的应用详情页,您会找到两个至关重要的凭证:

* **应用ID (App ID)**

* **应用密钥 (App Secret)**

请妥善保管它们。

为了方便调用和复用,我们来编写一个专门用于翻译的函数。有道翻译API的调用需要对参数进行签名,以下是一个完整的实现:

“`python

import requests

import hashlib

import time

import uuid

# — 有道翻译配置 —

YOUDAO_URL = ‘https://openapi.youdao.com/api’

APP_KEY = ‘YOUR_YOUDAO_APP_ID’ # 替换为你的应用ID

APP_SECRET = ‘YOUR_YOUDAO_APP_SECRET’ # 替换为你的应用密钥

def translate_text(text):

“””调用有道翻译API翻译文本”””

if not text:

return “”

data = {}

data[‘from’] = ‘en’ # 源语言:英文

data[‘to’] = ‘zh-CHS’ # 目标语言:简体中文

salt = str(uuid.uuid4())

curtime = str(int(time.time()))

sign_str = APP_KEY + truncate(text) + salt + curtime + APP_SECRET

sign = hashlib.sha256(sign_str.encode(‘utf-8’)).hexdigest()

data[‘q’] = text

data[‘appKey’] = APP_KEY

data[‘salt’] = salt

data[‘sign’] = sign

data[‘signType’] = ‘v3’

data[‘curtime’] = curtime

try:

response = requests.post(YOUDAO_URL, data=data)

response.raise_for_status() # 如果请求失败则抛出异常

result = response.json()

if result.get(‘errorCode’) == ‘0’:

return result[‘translation’][0]

else:

print(f”翻译API错误: {result}”)

return f”[翻译失败: {result.get(‘errorCode’)}]”

except requests.exceptions.RequestException as e:

print(f”请求翻译API时发生网络错误: {e}”)

return “[翻译网络错误]”

def truncate(q):

if q is None:

return None

size = len(q)

return q if size <= 20 else q[0:10] + str(size) + q[size-10:size]

# — 测试翻译函数 —

test_text = "Hello, world! This is a test for the Youdao Translate API."

translated_text = translate_text(test_text)

print(f"原文: {test_text}")

print(f"译文: {translated_text}")

“`

请将`APP_KEY`和`APP_SECRET`替换为您自己的凭证并运行。如果成功打印出中文译文,说明翻译模块也准备就绪了!

现在,我们将Reddit数据抓取和有道翻译两个模块无缝衔接起来。

我们的目标是获取帖子的核心信息(标题、正文、分数等)以及高赞评论。PRAW库让这个过程非常直观。

“`python

# (接续PRAW连接部分)

target_subreddit = “datascience” # 设定目标Subreddit

limit_posts = 10 # 设定抓取帖子数量

limit_comments = 5 # 每个帖子抓取的热门评论数量

subreddit = reddit.subreddit(target_subreddit)

print(f”开始从 r/{target_subreddit} 抓取数据…”)

scraped_data = []

for submission in subreddit.hot(limit=limit_posts):

# 抓取帖子信息

post_data = {

‘title_original’: submission.title,

‘text_original’: submission.selftext, # selftext是帖子的正文

‘score’: submission.score,

‘author’: str(submission.author),

‘url’: submission.url,

‘comments’: []

}

# 抓取该帖子下的热门评论

submission.comments.replace_more(limit=0) # 加载所有顶级评论

for top_level_comment in submission.comments[:limit_comments]:

post_data[‘comments’].append(top_level_comment.body)

scraped_data.append(post_data)

print(f”已抓取 {len(scraped_data)} 条帖子及其评论。”)

“`

接下来,我们遍历抓取到的数据,并逐一调用`translate_text`函数。

“`python

print(“开始翻译内容,请稍候…”)

translated_results = []

for post in scraped_data:

# 翻译标题和正文

title_translated = translate_text(post[‘title_original’])

text_translated = translate_text(post[‘text_original’])

# 翻译评论

comments_translated = [translate_text(comment) for comment in post[‘comments’]]

translated_results.append({

‘原始标题’: post[‘title_original’],

‘翻译标题’: title_translated,

‘原始正文’: post[‘text_original’],

‘翻译正文’: text_translated,

‘分数’: post[‘score’],

‘作者’: post[‘author’],

‘帖子链接’: post[‘url’],

‘原始评论’: ” | “.join(post[‘comments’]), # 将评论列表合并为字符串

‘翻译评论’: ” | “.join(comments_translated)

})

print(f”翻译完成一篇帖子: {post[‘title_original’][:30]}…”)

time.sleep(1.1) # 重要!避免API调用过于频繁

print(“所有内容翻译完成!”)

“`

我们在这里加入了 `time.sleep(1.1)`,这是一个简单的速率控制,确保每秒的API请求不超过1次,对Reddit和有道API都更加友好。

最后一步,将我们辛勤劳动的结果保存下来。Pandas的DataFrame是完美的选择。

“`python

import pandas as pd

# 将翻译结果列表转换为Pandas DataFrame

df = pd.DataFrame(translated_results)

# 保存为CSV文件,指定编码为utf-8-sig以正确处理中文

output_filename = f”{target_subreddit}_translated.csv”

df.to_csv(output_filename, index=False, encoding=’utf-8-sig’)

print(f”数据已成功保存到文件: {output_filename}”)

“`

运行整个脚本后,您会在项目目录下找到一个CSV文件。用Excel或Numbers打开它,就能看到一个整洁、中英对照的数据表格!

## 进阶优化:让你的脚本更专业、更强大 (2025年最佳实践)

一个好的项目不止于能跑通,更在于其健壮性和专业性。

`time.sleep()` 简单有效,但在更复杂的场景下,您应该检查API响应头中的速率限制信息(如果API提供的话),或者在代码中实现更复杂的重试逻辑(例如使用 `tenacity` 库)。

**绝对不要将API密钥直接写在代码里并上传到GitHub等公共平台!** 专业的做法是使用环境变量。

1. 在项目根目录下创建一个名为 `.env` 的文件。

2. 在 `.env` 文件中写入你的密钥:

“`

REDDIT_CLIENT_ID=your_client_id

REDDIT_CLIENT_SECRET=your_client_secret

REDDIT_USER_AGENT=your_user_agent

YOUDAO_APP_ID=your_youdao_id

YOUDAO_APP_SECRET=your_youdao_secret

“`

3. 在你的Python脚本中,使用`python-dotenv`库加载它们:

“`python

import os

from dotenv import load_dotenv

load_dotenv() # 加载.env文件中的变量

# 使用os.getenv()获取密钥

client_id = os.getenv(“REDDIT_CLIENT_ID”)

app_secret = os.getenv(“YOUDAO_APP_SECRET”)

# …以此类推

“`

这样,你的代码变得干净且安全。

当抓取量巨大时,一个接一个地请求API会非常耗时。Python的 `asyncio` 配合 `aiohttp` 库可以实现并发请求,即同时发送多个翻译请求并等待它们一起完成。这能将总耗时从几十分钟缩短到几分钟。虽然实现起来更复杂,但这是通往高性能爬虫的必经之路,也是2025年自动化脚本的趋势。

这里是整合了所有最佳实践(包括环境变量)的最终脚本。

`main.py`

“`python

import praw

import pandas as pd

import requests

import hashlib

import time

import uuid

import os

from dotenv import load_dotenv

# — 加载环境变量 —

load_dotenv()

# — Reddit API 配置 —

REDDIT_CLIENT_ID = os.getenv(“REDDIT_CLIENT_ID”)

REDDIT_CLIENT_SECRET = os.getenv(“REDDIT_CLIENT_SECRET”)

REDDIT_USER_AGENT = os.getenv(“REDDIT_USER_AGENT”)

# — 有道翻译 API 配置 —

YOUDAO_URL = ‘https://openapi.youdao.com/api’

YOUDAO_APP_ID = os.getenv(“YOUDAO_APP_ID”)

YOUDAO_APP_SECRET = os.getenv(“YOUDAO_APP_SECRET”)

def translate_text(text):

“””调用有道翻译API翻译文本”””

if not text:

return “”

# … (此处省略与上文完全相同的翻译函数代码)

data = {}

data[‘from’] = ‘en’

data[‘to’] = ‘zh-CHS’

salt = str(uuid.uuid4())

curtime = str(int(time.time()))

sign_str = YOUDAO_APP_ID + truncate(text) + salt + curtime + YOUDAO_APP_SECRET

sign = hashlib.sha256(sign_str.encode(‘utf-8’)).hexdigest()

data[‘q’] = text

data[‘appKey’] = YOUDAO_APP_ID

data[‘salt’] = salt

data[‘sign’] = sign

data[‘signType’] = ‘v3’

data[‘curtime’] = curtime

try:

response = requests.post(YOUDAO_URL, data=data)

response.raise_for_status()

result = response.json()

if result.get(‘errorCode’) == ‘0’:

return result[‘translation’][0]

else:

print(f”翻译API错误: {result}”)

return f”[翻译失败: {result.get(‘errorCode’)}]”

except requests.exceptions.RequestException as e:

print(f”请求翻译API时发生网络错误: {e}”)

return “[翻译网络错误]”

def truncate(q):

if q is None: return None

size = len(q)

return q if size <= 20 else q[0:10] + str(size) + q[size-10:size]

def main():

# — 初始化PRAW —

reddit = praw.Reddit(

client_id=REDDIT_CLIENT_ID,

client_secret=REDDIT_CLIENT_SECRET,

user_agent=REDDIT_USER_AGENT

)

# — 设置参数 —

target_subreddit = "MachineLearning"

limit_posts = 20

limit_comments = 5

subreddit = reddit.subreddit(target_subreddit)

print(f"开始从 r/{target_subreddit} 抓取 {limit_posts} 条热门帖子…")

# — 抓取数据 —

scraped_data = []

for submission in subreddit.hot(limit=limit_posts):

post_data = {

'title_original': submission.title,

'text_original': submission.selftext,

'score': submission.score,

'author': str(submission.author),

'url': submission.url,

'comments': []

}

submission.comments.replace_more(limit=0)

for comment in submission.comments[:limit_comments]:

post_data['comments'].append(comment.body)

scraped_data.append(post_data)

print(f"已抓取帖子: {submission.title[:50]}…")

# — 翻译数据 —

print("\n— 开始翻译内容,请耐心等待… —")

translated_results = []

for i, post in enumerate(scraped_data):

title_translated = translate_text(post['title_original'])

text_translated = translate_text(post['text_original'])

comments_translated = [translate_text(comment) for comment in post['comments']]

translated_results.append({

'原始标题': post['title_original'],

'翻译标题': title_translated,

'原始正文': post['text_original'],

'翻译正文': text_translated,

'分数': post['score'],

'作者': post['author'],

'帖子链接': post['url'],

'原始评论': " | ".join(post['comments']),

'翻译评论': " | ".join(comments_translated)

})

print(f"进度: {i+1}/{len(scraped_data)} | 正在翻译帖子: {post['title_original'][:30]}…")

time.sleep(1.1) # 遵守API速率

# — 保存数据 —

df = pd.DataFrame(translated_results)

output_filename = f"{target_subreddit}_translated_{int(time.time())}.csv"

df.to_csv(output_filename, index=False, encoding='utf-8-sig')

print(f"\n🎉 任务完成!数据已保存至: {output_filename}")

if __name__ == "__main__":

main()

“`

**最终成果展示:** 打开生成的CSV文件,您会看到类似这样的表格:

(这是一个示意图,实际内容为您抓取的Subreddit数据)

恭喜您!您已经成功构建了一个功能强大的自动化翻译机器人。通过这个项目,您不仅掌握了如何利用Python与PRAW和**有道翻译API**进行交互,更重要的是,您开启了通往全球信息宝库的大门。

以此为基础,您的下一个项目可以更加宏大:

* **舆情监控系统:** 持续监控与您品牌相关的关键词,一旦出现新帖子,立即翻译并通过邮件或Slack通知您。

* **数据可视化面板:** 使用`matplotlib`或`seaborn`库对翻译后的数据进行分析,例如,分析不同帖子的情绪倾向或讨论热点。

* **自动化内容聚合网站:** 创建一个简单的Web应用(使用Flask或Django),将多个您感兴趣的Subreddit的翻译内容聚合起来,打造成您的个人信息流中心。

技术的魅力在于创造。现在,轮到您来探索和构建了!

**Q1: 这个过程完全免费吗?**

A: 基本是免费的。Reddit API本身是免费的。有道翻译API为开发者提供了每月足量的免费调用额度,对于本项目中描述的抓取量(每天抓取几百上千条)是完全足够的。如果您的需求量极大,超出免费额度后,有道也提供了非常具有竞争力的付费方案。

**Q2: 抓取Reddit数据是否合法?**

A: 合法,但需遵守规则。Reddit鼓励开发者通过其API进行创造性的开发,但您必须遵守其[API使用条款](https://www.reddit.com/wiki/api)。关键在于:设置一个清晰的`user_agent`,并且不要以过高的频率请求API,以免对Reddit服务器造成负担。我们代码中的`time.sleep()`就是负责任的做法。

**Q3: 翻译质量如何?能处理俚语和梗吗?**

A: 质量非常高。这正是我们推荐**有道翻译API**的核心原因。其先进的NMT模型经过海量互联网语料的训练,对非正式的俚语、网络“梗”、缩写和技术黑话都有很好的理解和翻译能力,这使得它在处理Reddit这种社群内容时表现尤为出色。

**Q4: 我可以翻译成其他语言吗?**

A: 当然可以。有道翻译API支持多种语言之间的互译。您只需在`translate_text`函数中修改`’to’`参数即可,例如,修改为`’ja’`可以翻译成日语,修改为`’ko’`可以翻译成韩语。具体支持的语言列表,请查阅有道智云的官方文档。